La conferencia de RecSys 2020 tuvo lugar la semana pasada de una nueva forma debido a la pandemia. Debería haber sido en Río de Janeiro con el resto de la comunidad científica para hablar de sistemas de recomendación como todos los años. La Covid-19 cambió nuestros planes y la conferencia se llevó a cabo en línea. A pesar de este paso a la esfera virtual, la diferencia horaria y la falta de reuniones físicas, aún pudo aprovecharse. En este artículo, vuelvo al discurso de apertura que dio Filippo Menczer de la Universidad de Indiana. Titulado “4 razones por las que las redes sociales nos hacen vulnerables a la manipulación”, nos permitió hacer un balance de un tema complejo y exponer el papel real de las redes sociales en la formación de cámaras de eco.

5 ideas para recordar

- Los más vulnerables a la manipulación no están expuestos a los que intentan establecer la verdad (verificación de datos).

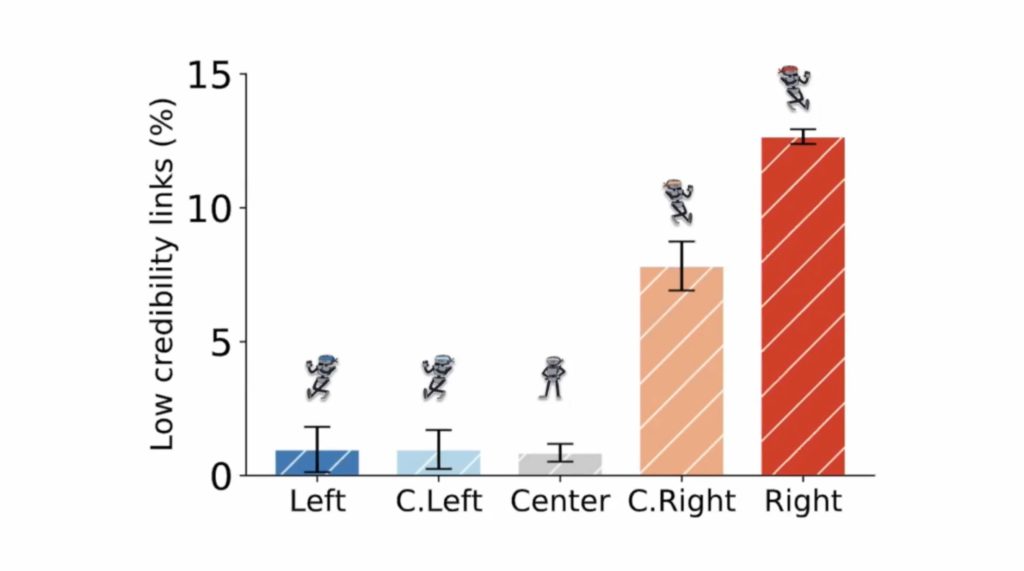

- Los conservadores son los más propensos a compartir información falsa. la viralidad de la información incorrecta y precisa sigue casi la misma dinámica.

- Twitter tiende a acercar las opiniones de los demócratas centrales, pero no las de los republicanos.

- Cuando los bots se infiltran en el 1% de una red, pueden controlarla y hacer que disminuya la calidad de la transmisión de información.

Consejo 1: cámaras de eco

Ya he dedicado muchos artículos en este blog a las cámaras de eco y a filtrar burbujas. El primer comentario de Filippo se refería a su propia experiencia con cámaras de eco después de un “ataque” a su laboratorio a través de una campaña de desinformación.

Los sesgos están dentro de nosotros y las redes sociales son un catalizador que acelera la formación de las cámaras de eco.

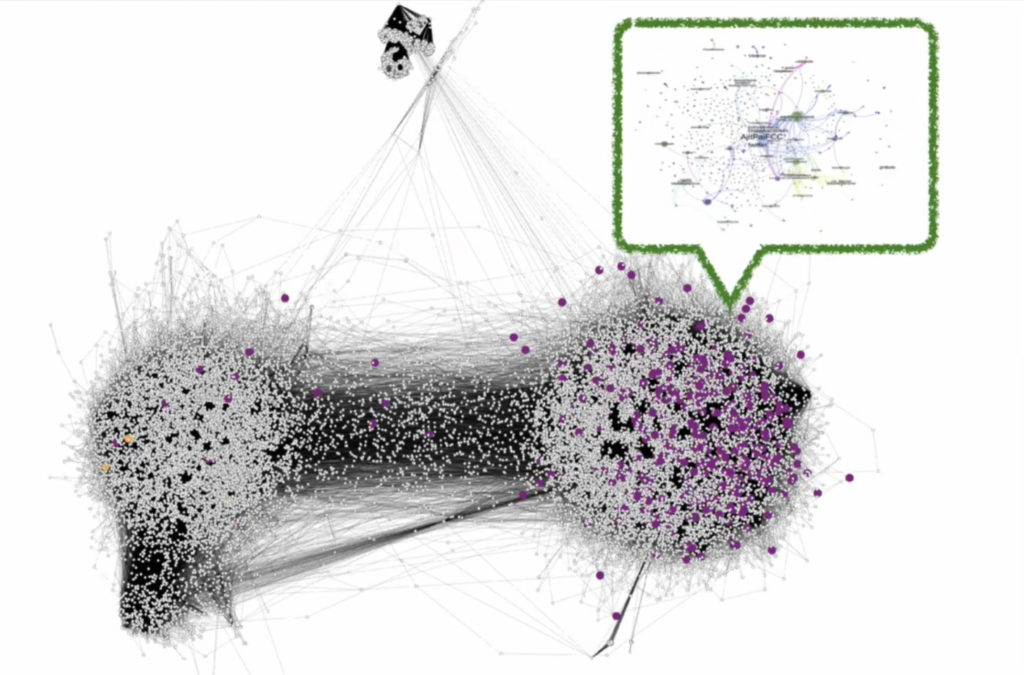

El estudio de estos ataques mostró que se originaron en un grupo de personas/bots del ala conservadora (republicana). Esto se ilustra en la imagen a continuación, donde puedes ver que la red de desinformación (en un círculo verde) está completamente incrustada en las cuentas de Twitter ubicadas en el lado derecho del tablero de ajedrez político. Dos puntos amarillos (verificadores de datos) a la izquierda permanecen inaudibles. En otras palabras, las personas vulnerables a los intentos de desinformación no tienen la oportunidad de estar expuestas a hechos reales que les permitirían cambiar de opinión.

Las cámaras de eco no son tanto el resultado de algoritmos de recomendación (otro argumento contra burbujas de filtro) sino más bien el resultado del comportamiento de los propios individuos. En una simulación muy esclarecedora, el equipo de Filippo mostró cómo se forman las cámaras de eco. Es la acción “unfollow” (dejar de seguir a alguien) la que conduce gradualmente a la formación de cámaras de eco. Y como señala Filippo, los sistemas de recomendación que tienen como objetivo contrarrestar las cámaras de eco solo logran, en el mejor de los casos, ralentizar su formación. Los sesgos están en nosotros y las redes sociales son un catalizador que acelera la formación de cámaras de eco. Si quieres profundizar en el tema, te sugiero que te leas este artículo.

Puedes jugar con esta simulación tú mismo a través de la página del laboratorio de Filippo.

En resumen, estas cámaras de eco son el resultado de sesgos inherentes a nuestras creencias, especialmente políticas. Lo que no dejarás de cuestionar es la prueba científica que se presenta de la mayor probabilidad de que los conservadores y ultraconservadores compartan lo que se llama modestamente “vínculos de baja credibilidad” (en otras palabras, noticias falsas).

Consejo 2: demasiada información

No habrá pasado desapercibido para nadie que vivimos en una sociedad donde la información se ha vuelto omnipresente. La carga cognitiva nunca ha sido más significativa en la historia de la humanidad. Por lo tanto, los sistemas de derivación son potencialmente útiles para encontrar la información requerida. El problema es que en el desorden de información que nos llega todos los días, hay cosas buenas y malas. Por lo tanto, surge la pregunta de si podemos clasificarlo de acuerdo con la calidad de la información. La respuesta es no. La viralidad de la información verdadera y falsa sigue casi la misma dinámica. Las noticias reales son solo un poco más populares que las “noticias falsas”. Esto es preocupante.

Para entender esta dinámica, es fundamental saber que la viralidad de una publicación depende de hecho de la estructura de la red social. Una red social que se asemeja a una red “humana” permite el mejor rendimiento. Para ello, la presencia de “hubs” es fundamental (aquellas personas de retransmisión en el sistema que están conectadas a muchas personas).

Consejo 3: el sesgo de la plataforma

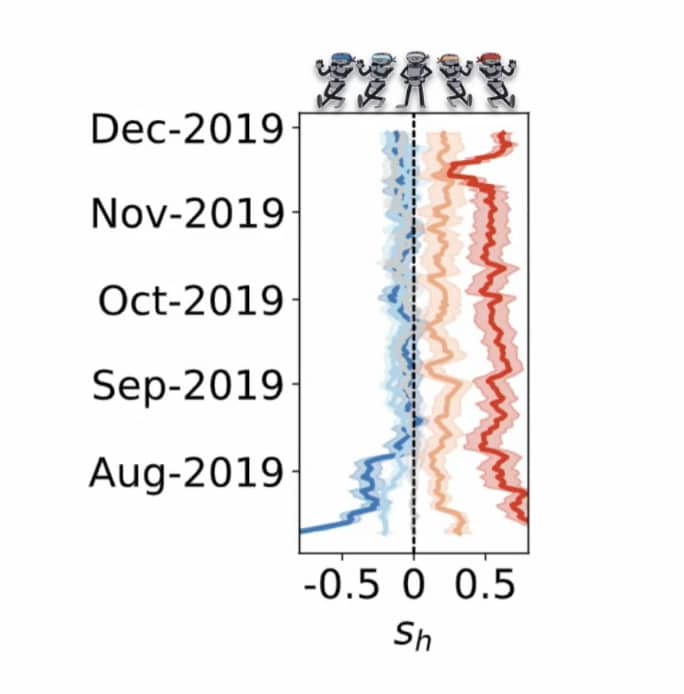

Los conservadores acusan regularmente a Twitter de sesgar los resultados y ocultar cierta información a favor de los demócratas. Lo que ha demostrado Filippo Menczer es que Twitter tiende a “normalizar” las opiniones de los demócratas. El siguiente gráfico muestra que las vistas más izquierdistas (en azul y en agosto de 2019) se están acercando al centro a medida que pasa el tiempo. Esto es alentador porque es necesario acercar las corrientes opuestas para restablecer la comunicación y evitar las cámaras de eco. El problema es que la misma dinámica no se aplica a los conservadores (en rojo). Su opinión sigue estando, a pesar del paso del tiempo, muy arraigada a la derecha.

El algoritmo no tiene nada que ver con eso. Jérôme Fourquet habla en su libro sobre los archipiélagos, y esto es precisamente lo que observamos aquí. Un archipiélago conservador que ha cortado todo contacto con personas que tienen opiniones diferentes y que mantiene su conservadurismo en el vacío.

Consejo 4: Manipulación de redes sociales a través de bots

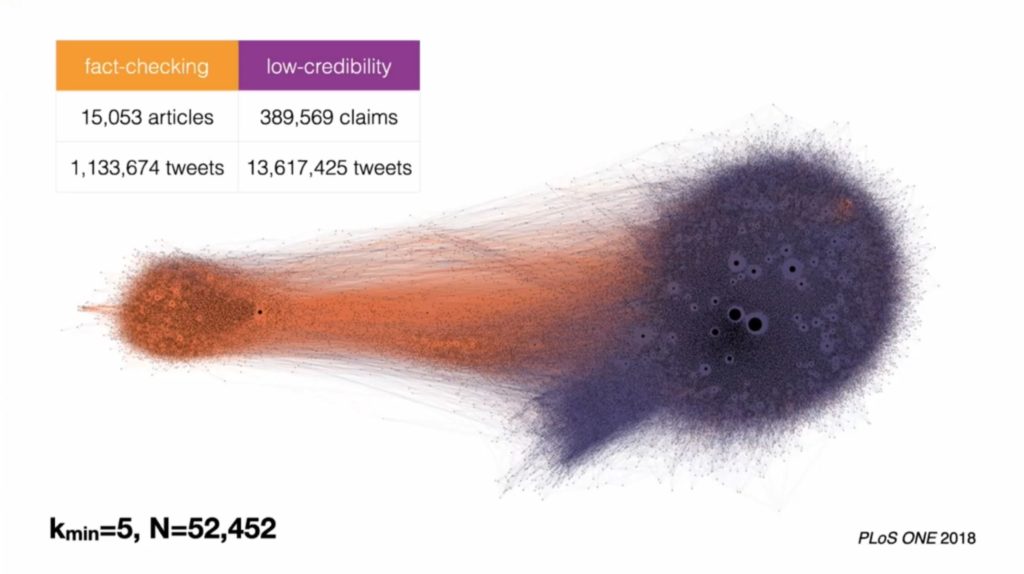

Filippo Menczer fue el primero en observar la actividad de los bots en Twitter en 2010. La siguiente ilustración es, de hecho, el primer testimonio de la acción de 2 bots que automáticamente retuitearon sus mensajes como en un infernal juego de ping-pong. El grosor de la línea corresponde al número de retweets (varios miles).

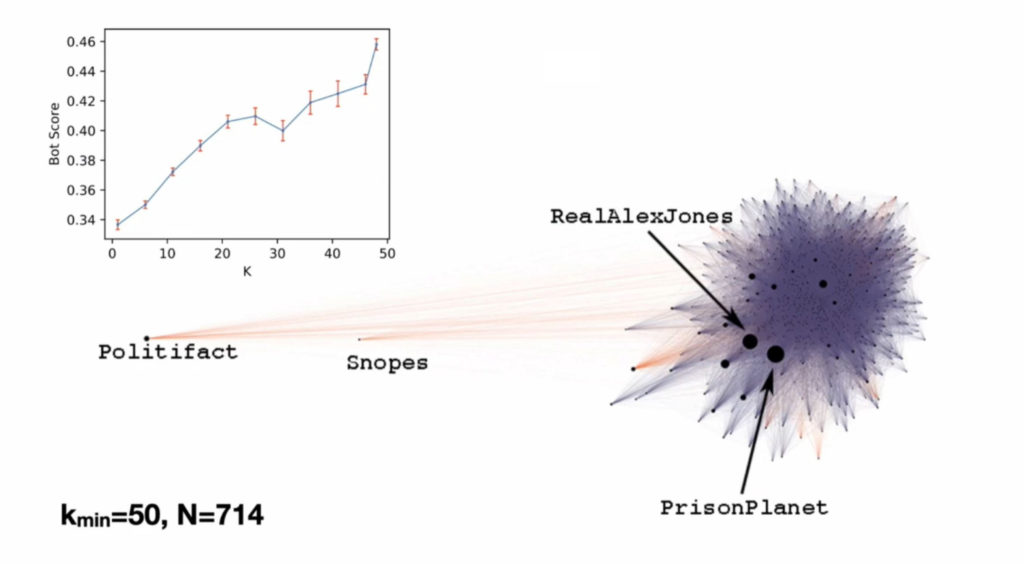

La siguiente visualización es de Hoaxy, otra aplicación del laboratorio de Filippo Menczer. Esta aplicación te permite visualizar la velocidad a la que se difunden noticias falsas e información real. El uso de datos de la actividad del usuario muestra lógicamente que las cuentas que comparten noticias falsas están completamente aisladas de aquellas que comparten información precisa.

Si nos adentramos en el corazón de la nebulosa de las “noticias falsas” a la derecha, descubrimos que los bots generan la mayoría de las transmisiones de noticias falsas. Es más probable que las cuentas más cercanas al “corazón” de esta red sean bots. La piratería de información falsa es una técnica utilizada por los bots para llenar un sistema y hacer que aparezca información falsa en el feed de Twitter de un humano del que espera un retweet.

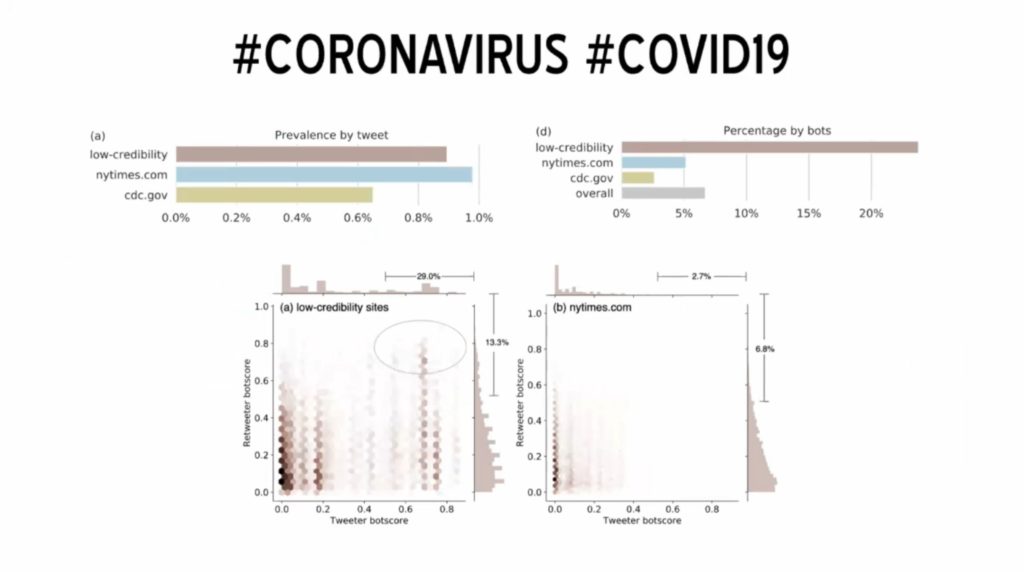

Los humanos hacen la mayoría de los retweets. Pero retuitean tanto noticias reales como falsas. Este es el efecto de esta piratería por parte de los bots, algunos de ellos pueden transmitir un enlace a una “noticia falsa” varios miles de veces. La consecuencia es que los humanos publicarán ambos tipos de información, como se muestra en el siguiente ejemplo sobre el COVID. Como se puede ver en el gráfico de la esquina superior izquierda, la difusión de información con poca credibilidad está al mismo nivel que la información de fuentes legítimas (NY Times o cdc.gov).

Otros análisis muestran que cuando los bots se infiltran en el 1% de la red, pueden controlarla y provocar una caída en la calidad de la transmisión de información.

Publicado en Investigación.